Commutation et routage réseaux informatiques : LAN - MAN - WAN - Gigabit - VLAN - VRRP - OSPF - BGP - MPLS

CHAPITRE XII : Commutation et routage : LAN - MAN - WAN

Commutation et routage LAN / MAN / WAN - Gigabit - VLAN - VRRP - OSPF - BGP - MPLS

Jusqu’à présent, nous avons utilisé différentes technologies, les unes adaptées aux réseaux locaux, les autres aux réseaux étendus.

Arrive un moment où les deux mondes doivent se rencontrer puisque la vocation des réseaux est de relier des hommes, qu’ils fassent ou non partie de la même entreprise.

Les réseaux locaux ont de plus en plus tendance à s’étendre au-delà d’un simple site pour former un réseau de campus, repoussant ainsi la frontière qui les sépare des réseaux étendus.

Dans ce chapitre, vous apprendrez :

Mettre en place un réseau fédérateur

Les données du problème

Le réseau de 800 postes dont nous avons décrit l’installation au chapitre 3 fonctionne parfaitement. Or, voici que l’ouverture d’un nouvel immeuble à proximité est annoncée. Elle implique un changement d’échelle, puisqu’il s’agit d’une tour de quinze étages, représentant environ 2 000 connexions, à raison de 130 par étage en tenant compte des postes de travail, des imprimantes, des serveurs, etc.

Le câblage a été conçu en fonction des besoins potentiels en matière d’architecture, incluant à la fois la téléphonie (la voix), le réseau local (les données), et la diffusion vidéo (l’image).

Les principes sont ceux qui ont été étudiés au chapitre 2.

La démarche

Il semble tout d’abord évident qu’il faudra au moins un réseau local par étage, afin de contrôler les flux, et sans doute plus, car il faut toujours s’attendre à des besoins spécifiques pour une population de 1 500 utilisateurs. Il est donc sage de prévoir une quarantaine de réseaux.

Un constat s’impose : s’il faut descendre près de quinze réseaux en collapse backbone, les équipements fédérateurs doivent disposer d’une très grande capacité. De plus, un réseau redondant est absolument nécessaire pour assurer une bonne qualité de service. En effet, à une telle échelle, un problème survient nécessairement quelque part (en vertu d’un principe de probabilité).

Le point central de l’architecture concerne donc les caractéristiques du réseau fédérateur pour lequel nous nous posons les questions suivantes :

Quelle technologie ?

Nous avons ici le choix entre Ethernet et ATM, sujet que nous avions abordé au cours du chapitre précédent.

Bien qu’adapté aux réseaux WAN, les constructeurs nous proposent d’utiliser ATM également pour les réseaux locaux. Choix étrange, car l’utilisation de ce protocole pose un certain nombre de problèmes :

Un certain nombre de standards permettent d’effectuer cette intégration. Il s’agit de LANE (LAN Emulation) pour les VLAN, de MPOA (Multi Protocol Over ATM) pour le routage et l’interconnexion des ELAN Emulated LAN) et de Classical IP pour la correspondance entre adresses ATM et adresses IP.

Face à cela, Ethernet nous offre la simplicité et une panoplie de solutions homogènes et évolutives, du 10 Mbit/s au Gigabit. Nous choisirons donc cette technologie pour l’ensemble de notre réseau local, du poste de travail au réseau fédérateur.

Quels équipements ?

Le réseau fédérateur concentre tous les flux entre les réseaux d’étage d’une part, et entre ces derniers et les ressources communes d’autre part. Cela suppose que la majorité des flux est émise entre les utilisateurs d’un étage donné.

Mais, de nos jours, la traditionnelle répartition 80/20 (80 % du trafic local sur le réseau et 20 % vers d’autres réseaux) n’est plus valable. Par exemple, la constitution de groupes de travail pluridisciplinaires amène des personnes dispersées au sein de l’immeuble à établir des liens de communication privilégiés entre elles.

Traduit en termes techniques, les flux réseau générés de manière privilégiée entre les postes de travail et les serveurs évolueront sans cesse.

En outre, la constitution de réseaux isolés regroupant des utilisateurs géographiquement dispersés pourrait s’avérer nécessaire.

La solution à ces besoins passe par les VLAN (Virtual Local Area Network). Cette technologie permet de définir des segments Ethernet logiques, indépendamment de la localisation géographique des postes de travail. Une trame émise au sein d’un VLAN ne sera diffusée qu’aux stations participant audit VLAN.

Jusqu’à présent, nous avons utilisé différentes technologies, les unes adaptées aux réseaux locaux, les autres aux réseaux étendus.

Arrive un moment où les deux mondes doivent se rencontrer puisque la vocation des réseaux est de relier des hommes, qu’ils fassent ou non partie de la même entreprise.

Les réseaux locaux ont de plus en plus tendance à s’étendre au-delà d’un simple site pour former un réseau de campus, repoussant ainsi la frontière qui les sépare des réseaux étendus.

Dans ce chapitre, vous apprendrez :

- à mettre en place un réseau fédérateur puis un réseau de campus ;

- à configurer des VLAN ;

- à établir le lien entre commutateurs LAN et routeurs WAN ;

- à configurer les protocoles de routage OSPF et BGP ;

- le fonctionnement de MPLS.

Mettre en place un réseau fédérateur

Les données du problème

Le réseau de 800 postes dont nous avons décrit l’installation au chapitre 3 fonctionne parfaitement. Or, voici que l’ouverture d’un nouvel immeuble à proximité est annoncée. Elle implique un changement d’échelle, puisqu’il s’agit d’une tour de quinze étages, représentant environ 2 000 connexions, à raison de 130 par étage en tenant compte des postes de travail, des imprimantes, des serveurs, etc.

Le câblage a été conçu en fonction des besoins potentiels en matière d’architecture, incluant à la fois la téléphonie (la voix), le réseau local (les données), et la diffusion vidéo (l’image).

Les principes sont ceux qui ont été étudiés au chapitre 2.

La démarche

Il semble tout d’abord évident qu’il faudra au moins un réseau local par étage, afin de contrôler les flux, et sans doute plus, car il faut toujours s’attendre à des besoins spécifiques pour une population de 1 500 utilisateurs. Il est donc sage de prévoir une quarantaine de réseaux.

Un constat s’impose : s’il faut descendre près de quinze réseaux en collapse backbone, les équipements fédérateurs doivent disposer d’une très grande capacité. De plus, un réseau redondant est absolument nécessaire pour assurer une bonne qualité de service. En effet, à une telle échelle, un problème survient nécessairement quelque part (en vertu d’un principe de probabilité).

Le point central de l’architecture concerne donc les caractéristiques du réseau fédérateur pour lequel nous nous posons les questions suivantes :

- Quelle technologie ?

- Quels équipements ?

- Routeurs ou commutateurs de niveau 3 ?

Quelle technologie ?

Nous avons ici le choix entre Ethernet et ATM, sujet que nous avions abordé au cours du chapitre précédent.

Bien qu’adapté aux réseaux WAN, les constructeurs nous proposent d’utiliser ATM également pour les réseaux locaux. Choix étrange, car l’utilisation de ce protocole pose un certain nombre de problèmes :

- Il faut mettre en place une mécanique complexe pour adapter un réseau multipoint tel qu’Ethernet à un réseau ne fonctionnant qu’avec des circuits virtuels point à point.

- Il faut mettre en place une mécanique non moins complexe pour interfacer les réseaux Ethernet avec le monde ATM.

- Le débit d’ATM est aujourd’hui limité à 622 Mbit/s, 155 Mbit/s étant le débit le plus fréquemment rencontré dans les entreprises. Face au Gigabit Ethernet, l’argument est donc mince.

Un certain nombre de standards permettent d’effectuer cette intégration. Il s’agit de LANE (LAN Emulation) pour les VLAN, de MPOA (Multi Protocol Over ATM) pour le routage et l’interconnexion des ELAN Emulated LAN) et de Classical IP pour la correspondance entre adresses ATM et adresses IP.

Face à cela, Ethernet nous offre la simplicité et une panoplie de solutions homogènes et évolutives, du 10 Mbit/s au Gigabit. Nous choisirons donc cette technologie pour l’ensemble de notre réseau local, du poste de travail au réseau fédérateur.

Quels équipements ?

Le réseau fédérateur concentre tous les flux entre les réseaux d’étage d’une part, et entre ces derniers et les ressources communes d’autre part. Cela suppose que la majorité des flux est émise entre les utilisateurs d’un étage donné.

Mais, de nos jours, la traditionnelle répartition 80/20 (80 % du trafic local sur le réseau et 20 % vers d’autres réseaux) n’est plus valable. Par exemple, la constitution de groupes de travail pluridisciplinaires amène des personnes dispersées au sein de l’immeuble à établir des liens de communication privilégiés entre elles.

Traduit en termes techniques, les flux réseau générés de manière privilégiée entre les postes de travail et les serveurs évolueront sans cesse.

En outre, la constitution de réseaux isolés regroupant des utilisateurs géographiquement dispersés pourrait s’avérer nécessaire.

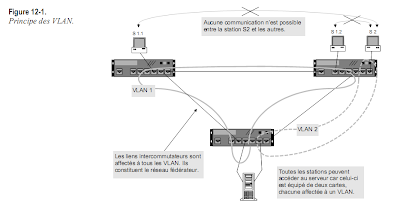

La solution à ces besoins passe par les VLAN (Virtual Local Area Network). Cette technologie permet de définir des segments Ethernet logiques, indépendamment de la localisation géographique des postes de travail. Une trame émise au sein d’un VLAN ne sera diffusée qu’aux stations participant audit VLAN.

Or, seuls les commutateurs permettent de créer des VLAN, c’est-à-dire de segmenter le réseau correspondant à des groupes d’utilisateurs indépendamment de leur localisation géographique.

De plus, nous avons vu au chapitre 3 que les commutateurs sont nécessaires pour des applications multimédias (téléphonie et visioconférence sur IP), pour de gros volumes de données et pour une question de fiabilité.

Si l’on veut répondre à tous ces besoins, il est donc nécessaire d’installer des commutateurs sur l’ensemble de notre réseau (eau et gaz à tous les étages, pour ainsi dire !). Le choix de ces équipements s’impose donc à la fois pour des questions de performances et d’architecture.

Nous choisissons donc la solution 100 % commutateurs.

Routeur ou commutateur de niveau 3 ?

L’intérêt de partitionner notre réseau en réseaux plus petits est de circonscrire localement les flux générés par un groupe d’utilisateurs, de créer des zones isolées, ou encore de réduire les flux générés par les broadcasts (surtout pour les grands réseaux).

La constitution de réseaux distincts (constituant chacun un domaine de broadcast MAC) nécessite cependant de les interconnecter quelque part. En effet, même s’ils appartiennent à des groupes différents, les utilisateurs doivent, à un moment ou à un autre, accéder à des ressources communes (serveur d’annuaire, passerelles fax, base de données centrale, PABX, accès Internet, etc.).

Une fonction de routage est donc nécessaire pour interconnecter ces différents réseaux, qu’ils soient physiquement ou virtuellement constitués.

À ce niveau, nous avons le choix entre deux types d’équipements : les routeurs et les commutateurs de niveau 3.

Comparé au commutateur de niveau 3, le routeur présente un certain nombre de désavantages : il est nettement moins performant et, de ce fait, dispose rarement d’interfaces Gigabit. Par ailleurs, il ne sait pas gérer les VLAN.

Ce dernier point mentionné implique que le routeur dispose d’autant d’interfaces qu’il y a de VLAN (si ceux-ci sont créés par port), ou d’autant d’adresses IP sur une interface qu’il y a de VLAN créés par adresse IP.

Pour les petits et moyens réseaux (moins de 800 postes) sans liens Gigabit, on peut envisager un routeur pour interconnecter quelques VLAN. Au-delà de ces restrictions, le commutateur de niveau 3 s’impose.

-------------------------------------------------------------------------------------------------------

Un commutateur de niveau 2 agit au niveau des couches physique et logique (niveaux 1 et 2). Il ne traite que les trames MAC. On parle de commutation de niveau 2 ou layer 2 switching.

Un commutateur de niveau 3, quant à lui, agit au niveau de la couche réseau (niveau 3). Il ne traite que les paquets IP. C’est l’équivalent d’un routeur mais en beaucoup plus performant. On parle de commutation de niveau 3 ou layer 3 switching.

-------------------------------------------------------------------------------------------------------

LES COMMUTATEURS DE NIVEAUX 2 ET 3

Un commutateur de niveau 2 agit au niveau des couches physique et logique (niveaux 1 et 2). Il ne traite que les trames MAC. On parle de commutation de niveau 2 ou layer 2 switching.

Un commutateur de niveau 3, quant à lui, agit au niveau de la couche réseau (niveau 3). Il ne traite que les paquets IP. C’est l’équivalent d’un routeur mais en beaucoup plus performant. On parle de commutation de niveau 3 ou layer 3 switching.

-------------------------------------------------------------------------------------------------------

Quelle architecture ?

Nous voilà donc confortés dans le choix des commutateurs. Mais quelle architecture retenir ? Et à quel débit ?

On le voit, pour notre réseau de 1500 postes, de nouvelles considérations viennent compliquer notre tâche, de nouveaux paramètres influent sur le choix de l’architecture. En fait, tout tourne autour du fédérateur, pièce maîtresse du réseau. Résumons :

1. Une architecture basée uniquement sur des commutateurs de niveau 2 a le mérite de la simplicité. Elle a été étudiée au chapitre 3. Si l’on veut créer des réseaux séparés, il faut employer des VLAN par port ou par adresses MAC, ce qui augmente la complexité d’exploitation.

2. Une architecture basée uniquement sur des commutateurs de niveau 3 est plus coûteuse.

Elle est cependant plus souple que la précédente, car on peut choisir les classes d’adresses IP et les combiner. L’architecture est identique à celle de la première solution, seule la technologie change.

3. Une architecture basée sur des routeurs est la moins performante de toutes et la moins souple (pas de VLAN possible). En fait, les routeurs sont plutôt destinés aux réseaux WAN.

4. Une architecture reposant sur un réseau fédérateur ATM est la plus complexe et la plus fragile, car elle impose une combinaison de plusieurs technologies. Son débit est, de plus, limité à 622 Mbit/s, ce qui est un handicap certain face au Gigabit Ethernet.

En fait, le routage n’est nécessaire qu’au niveau du réseau fédérateur, car tous les commutateurs d’étage y seront reliés.

En définitive, le choix se portera sur des commutateurs de niveau 2 pour les étages, et des commutateurs de niveau 3 pour le réseau fédérateur. Dans la pratique, ces derniers sont également des commutateurs de niveau 2 équipés de cartes de commutation de niveau 3.

Pour le reste, nous appliquerons les recettes indiquées au chapitre 3.

Les commutateurs d’étage sont équipés de cartes 10/100bT ainsi que de deux ports uplink Gigabit. Ils peuvent éventuellement être dotés de cartes 100bF ou de cartes gigabit pour connecter des serveurs délocalisés.

Les commutateurs fédérateurs sont principalement équipés de cartes gigabit pour être raccordés, d’une part, entre eux et, d’autre part, aux commutateurs d’étage. Ils peuvent éventuellement être dotés de cartes 10/100bT ou 1000bT, afin de connecter des serveurs situés dans des salles informatiques. Les cartes 1000bT offrent, en effet, une plus grande densité de port que leurs équivalents en fibre optique.

Les cartes en fibre optique sont utilisées partout où les distances sont supérieures à 90 mètres. Leur emploi est cependant systématisé au niveau du réseau fédérateur, même en dessous de cette distance, afin de disposer de configurations homogènes.

Configurer les VLAN

Même si les commutateurs fédérateurs sont équipés de cartes de commutation niveau 3, tous assurent la commutation de niveau 2. Le spanning tree doit donc être configuré sur tous les commutateurs, comme indiqué au chapitre 3.

De la même manière, un VLAN doit être configuré sur tous les commutateurs, afin qu’il soit connu de tous. Sur nos équipements (de marque Cisco), la création d’un VLAN par port s’effectue de la façon suivante :

set vlan 100 name VLAN_principal set vlan 100 2/1-48 Les ports 1 à 48 situés sur la carte n° 2 seront ainsi affectés au VLAN 100 que nous avons appelé « VLAN principal » .

L’opération suivante consiste à activer le protocole 802.1q entre tous nos commutateurs, afin d’étendre la portée du VLAN à l’ensemble de notre réseau. Ce protocole ne doit être activé que sur les ports qui raccordent des commutateurs entre eux, qu’on appellera des ports trunk (ports de liaison) :

-------------------------------------------------------------------------------------------------------

LE POINT SUR LES VLAN (IEEE 802.1Q)

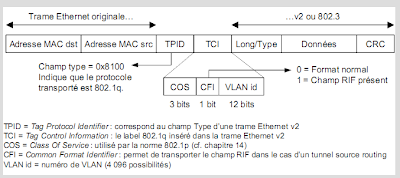

La norme 802.1q consiste à ajouter un champ à l’en-tête de la trame Ethernet initiale (802.3) à la fois pour gérer les VLAN et pour gérer des classes de service (802.1p).

Cette trame, généralement véhiculée qu'entre les commutateurs, permet d'étendre un VLAN à tout un réseau de commutateurs. Ces derniers ôtent le champ 802.1q lorsqu’ils transmettent la trame à un équipement terminal (PC, serveur, etc.) de manière à ce que ces derniers retrouvent une trame conforme à la norme 802.3 ou Ethernet v2.

La constitution des VLAN dépend de l’implémentation qui en est faite au sein des commutateurs. Il est ainsi possible de créer des VLAN :

• par port : toute trame entrant par un port est affectée d’office à un VLAN ;

• par adresse MAC source : toute trame disposant d’une telle adresse est affectée à un VLAN ;

• par protocole : toute trame véhiculant de l’IP, par exemple, est affectée à un VLAN ;

• par adresse IP source : toute trame véhiculant un paquet IP avec une telle adresse est affectée à un VLAN.

Un processus spanning tree (802.1d) est créé par VLAN. Par conséquent, les trames de broadcast et de multicast MAC émises au sein d’un VLAN ne seront pas propagées aux autres VLAN. En outre, les stations d’un VLAN ne pourront pas communiquer avec celles appartenant à un autre VLAN. Pour permettre cette fonction, il faut interconnecter les VLAN à l’aide d’un routeur ou d’un commutateur de niveau 3.

La norme spécifie également l’utilisation du protocole GVRP (GARP VLAN registration Protocol), qui permet de configurer les VLAN sur un seul commutateur, puis de les diffuser aux autres commutateurs participant au spanning tree. L’attribut échangé par les GID via le protocole GIP (cf. chapitre 3) est l’identifiant de VLAN sur 12 bits.

-------------------------------------------------------------------------------------------------------

Le protocole MSTP (Multiple Spanning Tree Protocol), issu du groupe de travail IEEE 802.1s, permet de créer plusieurs spanning tree (cf. chapitre 3). La répartition des VLAN sur plusieurs spanning tree présente l’avantage de pouvoir activer des liens qui sont désactivés par d’autres spanning tree. Il est donc possible de configurer ce protocole indépendamment pour chaque VLAN :

Les ports Gigabit peuvent, de plus, être configurés de manière à opérer un contrôle de flux.

Cela consiste en un signal envoyé à un autre commutateur pour lui demander de ralentir temporairement l’envoi de trames :

Dans notre architecture, il est également prévu d’agréger deux liens gigabit entre les deux commutateurs fédérateurs :

La configuration des VLAN au niveau des cartes Ethernet des PC et des serveurs est possible si elles supportent le protocole 802.1q, ce qui est le cas de nos cartes 3com.

Il est cependant préférable de ne pas utiliser cette facilité pour les raisons suivantes :

- Cela ajouterait une complexité supplémentaire aux tâches d’administration : il faudrait configurer à distance toutes les cartes des PC.

- Les utilisateurs trouveraient toujours le moyen de modifier la configuration de leur carte de manière à changer de VLAN.

- Pour éviter cela, il faudrait réaliser un contrôle au niveau des commutateurs, ce qui induirait une double exploitation.

Nous pourrions également créer des VLAN dynamiques par adresse IP. Là encore, l’exploitation est délicate et les modifications de la part des utilisateurs sont toujours possibles. L’affectation des VLAN par port a le mérite d’être simple, de faire partie de la configuration normale des commutateurs et de maîtriser l’étendue du VLAN sur notre réseau.

Mettre en place un réseau de campus

Nos deux commutateurs fédérateurs étaient suffisants pour accueillir les 15 réseaux d’étage.

Maintenant, nous devons connecter un autre site situé à quelques centaines de mètres, puis deux autre situés à quelques kilomètres. L’enjeu est maintenant d’étendre notre réseau fédérateur pour en faire un réseau de campus. On parle également de MAN (Metropolitan Area Network), bien qu’aucune technologie particulière ne soit associée à ce type de réseau. Il s’agit simplement d’une dénomination conceptuelle désignant les réseaux métropolitains à haut débit.

Si tous les bâtiments sont situés sur un terrain privé (par exemple, un campus universitaire), nous pouvons poser de la fibre optique comme nous l’entendons. Dans le cas contraire, soit un opérateur nous loue des câbles en fibre optique, soit nous devons obtenir une autorisation pour en poser entre nos bâtiments.

Pour ceux qui en doutaient encore, le Gigabit Ethernet convient parfaitement à ce type de besoins (voir les différents réseaux Ethernet au chapitre 3). Certains opérateurs proposent même ce service sur quelques centaines de kilomètres. Tout dépend de la fibre optique utilisée.

Côté performances, le Gigabit Ethernet est à la hauteur des débits annoncés :

- un débit réel de 761 Mbit/s pour des trames de 64 octets (soit 1 488 095 paquets par seconde) ;

- un débit réel de 986 Mbit/s pour des trames de 1 518 octets (soit 81 274 paquets par seconde).

Confortés dans notre choix du Gigabit, nous nous retrouvons avec plusieurs commutateurs fédérateurs à interconnecter.

Nous aurions pu mailler tous les commutateurs fédérateurs de manière à offrir des routes multiples. Cela est envisageable si les serveurs sont disséminés dans différents bâtiments.

Quand cela est possible, il est cependant préférable de respecter les principes suivants :

- Choisir deux commutateurs fédérateurs de campus qui fédéreront également les autres commutateurs fédérateurs de site (ou en dédier deux autres), de manière à centraliser les flux intersites au sein d’un nombre réduit de matrices de commutation. Ces deux équipements peuvent être situés dans deux bâtiments différents.

- Relier les deux commutateurs fédérateurs de campus par un lien très haut débit, dans notre cas quatre liens gigabits.

- Connecter les fédérateurs de site aux fédérateurs de campus par deux liens distincts en partage de charge et en redondance, de préférence sur deux commutateurs distincts, de manière à pallier la défaillance d’un équipement.

L’extension du réseau fédérateur se fait donc de manière très simple, sans remettre en cause les choix technologiques et l’architecture.

Il est à noter que, grâce aux VLAN, cette architecture permet à plusieurs sociétés de cohabiter sur la même infrastructure tout en étant isolées.

L’adressage et le routage IP

Nous avons décidé de créer un VLAN et d’affecter de manière statique les ports à ce VLAN, que nous avons appelé VLAN principal. D’autres VLAN peuvent être crées pour des réseaux dédiés.

Cela implique d’affecter un subnet IP à chaque VLAN, et par conséquent de configurer nos cartes de commutation niveau 3 (fonctionnellement équivalentes, rappelons-le, à des routeurs). Pour notre VLAN principal, cela est réalisé comme suit, conformément à notre plan d’adressage établi au chapitre 5 :

L’encapsulation « isl » (Inter-Switch Link) active le protocole propriétaire Cisco équivalent de la norme 802.1q. Dans ce cas particulier, nous ne pouvons faire autrement.

La carte de commutation de niveau 3 dispose ainsi d’un attachement sur le VLAN principal, qui est réalisé au niveau de la matrice de commutation. La création de tout autre VLAN sera réalisée sur le même modèle.

Le routage entre VLAN, et donc entre subnets IP, est effectué par la carte de commutation.

Pour sortir du VLAN principal, les PC et les serveurs doivent connaître la route de sortie, c’est-à-dire la route par défaut (default gateway), comme cela était le cas au chapitre 9.

Mais, cette fois, elle doit pointer sur l’adresse IP de la carte de commutation, à savoir 10.0.0.1.

Sur chaque VLAN, la passerelle par défaut des PC et des serveurs pointe donc sur l’adresse IP du commutateur de niveau 3 attaché audit VLAN.

La redondance du routage

Si, comme sur notre site parisien, nous disposons de deux commutateurs fédérateurs, chacun équipé d’une carte de commutation de niveau 3 (carte de routage), il est intéressant d’assurer la redondance de la route par défaut vis-à-vis des PC et des serveurs. Sur nos équipements, cela est réalisé grâce à la fonction HSRP (Hot Standby Router Protocol).

Le principe repose sur un groupe de n routeurs (ou cartes de commutation de niveau 3 dans notre cas), dont l’un est désigné actif. Comme d’habitude, chaque interface est associée à une adresse IP et à une adresse MAC. Mais le routeur actif reçoit en plus une adresse IP (définie comme route par défaut) associée à une adresse MAC qui seule répond au protocole de résolution d’adresses ARP (voir chapitre 5). En cas de défaillance du routeur actif, un nouveau routeur est élu parmi les N-1 restants en fonction des priorités affectées au sein du groupe HSRP, qui s’approprie les adresses HSRP (MAC et IP) :

La route par défaut configurée sur les PC et serveurs est celle de l’adresse HSRP, à savoir 10.0.0.1.

Ce principe peut être appliqué à chaque VLAN. Il est alors conseillé d’affecter les priorités de telle manière que chacune des cartes de commutation de niveau 3 soit active au moins pour un VLAN, et ce afin de répartir la charge de routage.

Certaines piles IP, comme celle de Windows NT, intègrent un mécanisme de détection de panne du routeur par défaut (dead gateway detection), tel que décrit dans la RFC 816.

Si la station constate qu’elle ne parvient plus à joindre son routeur par défaut, elle en choisira un autre parmi une liste définie dans le menu des propriétés de TCP/IP, case « Avancé… », section « Passerelle ». Pour activer ce mécanisme de détection, il faut positionner à « 1 » la clé de registre « HKEY_LOCAL_MACHINE\System \CurrentControlSet\Services\Tcpip\Parameter\EnableDeadGWDetect ».

-------------------------------------------------------------------------------------------------------

LE POINT SUR VRRP (RFC 2338)

Le protocole VRRP (Virtual Router Redundancy Protocol) reprend les principes du protocole HSRP (Hot Standby Router Protocol – RFC 2281) spécifié par Cisco. Les formats des paquets sont en revanche différents, ce qui rend ces deux protocoles incompatibles.

Le but est ici d’offrir une redondance de routeurs pour les machines (notamment les PC) utilisant le mécanisme de passerelle par défaut (default gateway). Même si plusieurs routeurs sont connectés à un segment Ethernet, la passerelle par défaut des PC pointera vers une seule adresse IP, celle d’un des routeurs choisis par l’administrateur du réseau.

Le protocole VRRP permet d’ajouter, en plus des adresses propres à chaque routeur, une adresse IP virtuelle vers laquelle les passerelles par défaut peuvent pointer. À un instant donné, seul le routeur désigné maître détiendra l’adresse virtuelle, et pourra assurer le traitement des paquets à destination de cette adresse.

Ainsi, lorsque la pile IP du PC devra résoudre, grâce à ARP, l’adresse de sa passerelle par défaut, seul le routeur maître répondra en indiquant l’adresse MAC virtuelle.

Le routeur maître envoie un paquet d’annonce à intervalle régulier. Si les autres routeurs n’en reçoivent plus au bout de l’intervalle de temps spécifié dans le dernier paquet reçu (par défaut une seconde), ils considèrent que le routeur maître est en panne et entrent alors dans un processus d’élection en envoyant des annonces. Celui dont la priorité est la plus élevée, devient alors maître et prend le contrôle de l’adresse virtuelle.

Les paquets VRRP disposent du numéro de protocole 112. Ils sont envoyés dans des paquets IP à destination de l’adresse multicast 224.0.0.18, dont l’adresse source est la véritable adresse IP du routeur et dont le TTL est obligatoirement fixé à 255. Le tout est envoyé dans une trame MAC d’adresse source 00-00-5E-00-01-xx où “ xx ” représente le numéro d’identification du routeur virtuel (identique au champ “ n° id routeur virtuel ” du paquet VRRP).

De son coté, HSRP fonctionne au-dessus d’UDP avec l’adresse multicast 224.0.0.2 et un TTL fixé à 1.

L’adresse MAC virtuelle utilisée est 00-00-0C-07-AC-xx.

Un même routeur peut participer à plusieurs groupes VRRP et plusieurs groupes VRRP peuvent cohabiter sur un LAN. Si, via le système des priorités, on s’arrange pour que chaque routeur d’un LAN soit maître pour un groupe, et, si on répartit les passerelles par défaut des PC sur chacune des adresses virtuelles, il est alors possible de partager la charge de routage entre les routeurs.

Les mécanismes classiques d’icmp-redirect et de proxy ARP sont toujours opérants.

-------------------------------------------------------------------------------------------------------

La rencontre du LAN et du WAN

Les routeurs qui interconnectent notre site aux autres peuvent directement être raccordés au réseau fédérateur. Nous préférons cependant créer un VLAN spécifique, afin de marquer la frontière entre les deux mondes, ce qui procure certains avantages :

- Tout changement d’architecture ou de configuration du LAN n’affecte pas le WAN, et inversement.

- La gestion du WAN peut être centralisée à partir d’un autre site, ce dernier gardant son autonomie sur le LAN.

- Idem lorsque les routeurs sont gérés par un ou plusieurs opérateurs.

Comme pour le VLAN principal, il faut affecter un subnet IP au VLAN WAN, puis des adresses IP aux cartes de commutation et à HSRP. Un subnet de 30 adresses, pris dans notre plan d’adressage, sera largement suffisant :

Il suffit ensuite de configurer le routage entre nos commutateurs LAN et le routeur WAN.

La manière la plus simple de le faire est de définir des routes statiques, soit une par défaut, soit explicitement pour chaque site distant connu :

Inversement, nous indiquons au routeur comment joindre le VLAN principal du site parisien :

ip route 10.0.0.0 255.252.0.0 10.0.9.33

int e0

ip address 10.0.9.36 255.255.255.224

Sur Toulouse, nous avons deux routeurs WAN qui peuvent être redondants pour des liaisons Frame-Relay. Il est alors possible de configurer HSRP à la fois sur les routeurs WAN et sur les routeurs LAN (les cartes de commutation de niveau 3).

Le routage sur le WAN - OSPF

Une fois arrivés sur le WAN, les paquets IP se trouvent face à de multiples routes allant vers la même destination.

Il est envisageable de programmer tous les routeurs avec des routes statiques, comme nous l’avons fait précédemment, mais cette tâche peut s’avérer complexe et fastidieuse, surtout s’il faut envisager des routes de secours.

Sur le WAN, le plus simple est d’utiliser un protocole de routage dynamique. Nous avons alors le choix entre RIP et OSPF (voir encadré). Ce dernier est cependant le plus performant et le plus répandu, même s’il est un peu plus complexe à programmer. Nous choisissons donc OSPF.

Configurer le routage OSPF

La première tâche est d’activer le routage OSPF. Sur nos routeurs Cisco, il faut attribuer un numéro de processus, car plusieurs instances d’OSPF peuvent fonctionner simultanément :

router ospf 1

Avec OSPF, la première tâche est de définir l’aire 0, appelée backbone area.

-------------------------------------------------------------------------------------------------------

QU’EST-CE QU’UN PROTOCOLE DE ROUTAGE ?

Le routage est l’action de commuter les paquets d’un réseau IP à l’autre en fonction de leur adresse IP de destination. Le routeur se base sur des routes statiques (configurées par l’administrateur) et dynamiques (apprises par des protocoles de routage).

Le routeur maintient ainsi une base de données des coûts des routes associées, ce qui permet de calculer le meilleur chemin.

Afin de réduire le trafic réseau généré par les protocoles de routage, de réduire la taille des bases de données et de déléguer l’administration, les réseaux IP sont découpés en domaines de routage appelés sys-

tèmes autonomes (AS, Autonomous System).

Les protocoles spécialisés dans le routage au sein d’un AS sont de type IGP (Interior Gateway Protocol). Les plus courants sont RIP (Routing Information Protocol), OSPF (Open Shortest Path First) et EIGRP (Enhanced Interior Gateway Routing Protocol). Les protocoles spécialisés dans le routage inter AS sont de type EGP (Exterior Gateway Protocol) dont le plus répandu est BGP (Border Gateway protocol).

Au sein d’un AS, tous les routeurs disposent de la même base de données décrivant la topologie de l’AS.

Les IGP utilisent deux types d’algorithmes pour calculer les routes : celui à vecteur de distance (Bellman-Ford) utilisé par RIP, et celui de l’arbre du plus court chemin (Dijkstra), plus performant, qui est utilisé par OSPF.

-------------------------------------------------------------------------------------------------------

Même si de multiples configurations sont possibles avec OSPF, il est cependant conseillé de respecter les règles suivantes :

- L’aire 0 doit couvrir toutes les interfaces WAN des routeurs (c’est-à-dire les interfaces série, Frame-Relay, ATM, LS, RNIS, etc.).

- Une aire doit être définie par site ou par groupe de sites fédérés autour d’un campus.

L’intérêt est de pouvoir contrôler la diffusion des routes, par exemple, d’empêcher qu’un subnet parisien puisse être vu des autres sites.

Étant donné que notre plan d’adressage défini au chapitre 5 prévoit l’affectation d’un subnet complet à l’ensemble des liaisons WAN, une seule commande sur chaque routeur est nécessaire pour affecter l’aire 0 :

L’aire OSPF est un numéro sur 32 bits qui peut être noté à la manière d’une adresse IP. La notation du masque associé au subnet à annoncer utilise, quant à elle, une convention inverse à celle utilisée pour les adresses IP (les bits à « 0 » indiquent la partie réseau).

Côté LAN, il n’y a pas de contrainte particulière à l’affectation d’une aire. Nous choisissons d’en affecter une par site (ou par campus) si cela se révélait nécessaire.

C’est justement le cas à Toulouse, car nous avons deux routeurs, connectés à l’aire 0 d’un côté et au même réseau local de l’autre. Afin que ces deux routeurs puissent échanger leurs tables de routage et se secourir mutuellement, il faut positionner leur interface locale dans une aire.

S’il n’y a que deux routeurs, le plus simple est de tout mettre dans l’aire 0. Si le réseau de Toulouse grandit au point d’intégrer plusieurs routeurs (ou cartes de commutation de niveau 3), on peut envisager de créer une aire sur ce site, afin de réduire le trafic sur le WAN et de mieux contrôler la diffusion des routes :

network 10.4.0.0 0.3.255.255 area 0.0.0.2

Redondance en cas de panne

En reprenant le réseau Frame-Relay que nous avons construit au chapitre 11, nous pouvons apercevoir que, en cas de panne du routeur de Strasbourg, l’aire backbone serait coupée en deux, empêchant toute diffusion des routes. Même s’il y a continuité du réseau local, l’aire backbone est séparée par l’aire 2.

-------------------------------------------------------------------------------------------------------

LE POINT SUR OSPF (RFC 2328)

Le protocole OSPF (Open Shortest Path First) découpe l’AS (Autonomous System) en aires. Toutes les aires doivent être adjacentes à l’aire 0 (backbone area) qui doit être contiguë. Si elle ne l’est pas, un lien virtuel doit être configuré pour assurer sa continuité logique. Les paquets routés entre aires doivent tous passer par la backbone area via les routeurs de bordure.

Les routeurs diffusent régulièrement des messages d’annonce LSA (Link State Advertisement) pour indiquer quels réseaux leur sont directement attachés. Les LSA sont diffusés à tous les routeurs de l’aire ; ils permettent à chacun d’entre eux de disposer de la même base de données d’état des liens et de calculer l’arbre du plus court chemin dont il est la racine. Un routeur gère autant de bases de données et calcule autant d’arbres qu’il y a d’aires auxquelles il est connecté.

Les routeurs diffusent régulièrement des messages Hello afin d’annoncer leur présence à leurs voisins sur les réseaux multipoints supportant le broadcast (par exemple Ethernet). Celui dont la priorité est la plus grande est élu routeur désigné ; il a la charge d’inclure ce réseau dans ses LSA. Sur les réseaux Ethernet, les messages sont envoyés dans des paquets multicasts 224.0.0.5.

Dans la backbone area, les routeurs de bordure s’échangent les bases de données des aires auxquelles ils sont rattachés. Ils calculent les meilleures routes qui sont ensuite diffusées aux routeurs intra-aire. Les routeurs intra-aire calculent la meilleure route pour sortir de l’aire (via un routeur de bordure). Le routeur frontière (qui peut être situé n’importe où dans l’AS) assure le même rôle pour les routes permettant de sortir de l’AS.

Quatre types de LSA sont échangés :

• router-LSA : émis par tous les routeurs d’une aire pour décrire l’état et indiquer le coût de leur interface.

• network-LSA : émis par les routeurs désignés pour annoncer les réseaux de type broadcast (Ethernet, par exemple) ;

• summary-LSA : émis par les routeurs de bordure ;

• AS-external-LSA :émis par les routeurs de frontière.

Aucun AS-external-LSA n’est envoyé dans les aires configurées en stub area. À la place, le routeur de bordure diffuse une route par défaut.

-------------------------------------------------------------------------------------------------------

Il est à noter que ce cas de figure n’existerait pas si Toulouse ne disposait que d’un seul routeur ou si les interfaces Ethernet des deux routeurs étaient situées dans l’aire 0.

La solution à ce problème passe par la création d’un lien virtuel entre les deux routeurs de Toulouse :

Ce lien permet d’assurer la continuité de l’aire backbone via l’aire de transit de Toulouse.

Ajustement des paramètres

Diffuser les routes statiques

Certains sites peuvent comporter des routeurs configurés uniquement avec des routes statiques. Si ces routes doivent être connues des autres sites, il est alors impératif de les diffuser au processus OSPF, de manière à ce que ce dernier les diffuse dynamiquement à ses voisins :

router ospf 1

redistribute static

Modifier le coût des routes

Pour calculer le coût des routes, et donc choisir la meilleure, OSPF se base sur la bande passante du lien. Sur nos routeurs, il est nécessaire de l’indiquer manuellement, par exemple 512 Kbit/s sur les routeurs de Toulouse :

int s0

bandwidth 512

Par défaut, le coût associé à l’interface est de 100 000 divisé par le débit exprimé en Kbit/s, ce qui donne, par exemple, un coût de 1 562 pour un débit de 64 Kbit/s. Il est néanmoins possible de le modifier, comme suit :

Limiter la diffusion des routes

Dans certains cas, il peut être intéressant de limiter la diffusion de certaines routes afin qu’elles ne soient pas connues d’autres sites, par exemple pour des questions de confidentialité ou pour forcer le chemin à emprunter :

De la même manière, un routeur peut ne pas accepter une route si, par exemple, le site d’Orléans doit être caché uniquement à celui de Londres :

Modifier la fréquence des échanges

Les routeurs OSPF voisins s’échangent des paquets Hello selon une périodicité qu’il est pos-sible de modifier :

Forcer l’élection du routeur désigné

Lorsque, comme cela est le cas à Toulouse, il existe deux routeurs sur le même réseau Ethernet, seul le routeur désigné va diffuser le subnet IP de l’aire n° 2. Est élu « désigné » le routeur dont la priorité est la plus haute ; en cas de niveau de priorité identique, c’est celui dont l’adresse IP est la plus haute :

Les performances d’OSPF

La RFC 1245 fournit quelques statistiques relevées sur les routeurs de l’Internet :

- Chaque entrée de la base d’états de liens est mise à jour toutes les 30 minutes en moyenne.

- Selon les cas, l’arbre du plus court chemin est recalculé toutes les 13 à 50 minutes.

- En moyenne, un paquet d’annonce contient trois LSA.

- Pour 2 000 entrées dans une base de données OSPF, la bande passante consommée par l’émission des LSA représente moins de 0,5 Kbit/s.

Le temps CPU pour calculer l’arbre du plus court chemin (algorithme de Dijsktra) est de l’ordre de n*log(n) pour N routes et 200 routeurs, soit environ 15 millisecondes pour un processeur de 10 Mips. En découpant un système autonome en aires, la charge CPU est réduite, car il y a moins de routeurs à prendre en compte, le calcul SPF étant réalisé au sein d’une aire.

Le routage entre systèmes autonomes - BGP

Avec OSPF, votre réseau fonctionne de manière indépendante avec son système autonome OSPF, tout comme le fait une autre entreprise ou un ISP avec le leur. Dans certaines entreprises, on peut envisager de découper son réseau en domaines administratifs distincts, chacun d’eux étant sous la responsabilité d’une équipe d’exploitation indépendante. Ce type de besoin s’exprime également avec l’Internet où chaque ISP ne gère que sa portion de réseau. L’autre intérêt de ce découpage est qu’il limite la taille des tables de routage OSPF.

Arrive un moment où il faut interconnecter ces systèmes autonomes, que ce soit en entreprise ou sur Internet. L’échange des informations de routage entre AS est alors réalisé à l’aide du protocole BGP (Border Gateway Protocol).

Un routeur BGP peut injecter automatiquement toutes les routes apprises de BGP dans OSPF, afin qu’elles soient diffusées dans le reste de l’AS. En retour, il ne faut pas réinjecter les routes OSPF dans BGP, mais seulement y injecter les routes de l’AS, ce qui implique une configuration manuelle. Le routeur R51 doit donc être configuré comme suit :

Il est noter que pour BGP la commande « network » indique la liste des réseaux à annoncer, tandis que pour OSPF, elle spécifie les interfaces prises en compte par le processus.

Les configurations des autres routeurs sont similaires, par exemple, celle de R21 :

-------------------------------------------------------------------------------------------------------

LE POINT SUR BGP (RFC 1771 À 1774)

L’objectif de BGP (Border Gateway Protocol) est de diffuser les routes entre des systèmes autonomes tels que ceux d’OSPF. Le principe consiste à injecter manuellement les routes d’un AS dans BGP ; ce dernier annonce ses routes aux routeurs BGP des autres AS qui les réinjectent ensuite dans le routage interne à leur AS respectif.

À leur initialisation, les routeurs BGP ouvrent des sessions TCP (port 179) avec leurs partenaires (peers) et échangent l’intégralité de leur table de routage, puis uniquement les mises à jour par la suite.

Quatre types de messages sont ainsi échangés :

• Open contient des informations relatives au routeur BGP qui envoie ce message : l’AS dans lequel il est, le délai par défaut du keepalive, son identifiant (généralement son adresse IP), ainsi que des paramètres optionnels relatifs à l’authentification.

• Keepalive est envoyé régulièrement aux partenaires pour indiquer que le routeur est toujours actif.

• Notification est envoyé lorsqu’une erreur a été détectée (valeur non conforme dans le message, réponse non reçue dans les temps, erreur de format du message, erreur de procédure, etc.).

• Update contient d’éventuelles routes précédemment annoncées et qui ne sont plus valides, ainsi que les routes actives associées à l’adresse du routeur de bordure et la liste des AS à traverser pour y aller.

Les messages “ Update ” sont propagés de routeur en routeur : à chaque sortie d’AS, le routeur BGP ajoute son numéro d’AS dans la liste AS_PATH, permettant ainsi de reconstituer le chemin d’AS. Chaque routeur BGP communique ainsi à son partenaire la liste des réseaux atteignables (NLRI) via tel routeur indiqué dans NEXT_HOP.

S’il existe plusieurs routes entre deux AS, les routeurs BGP de chaque AS calculent la meilleure route vers l’autre AS à l’aide des attributs MULTI_EXIT_DISC et LOCAL_PREF.

Les informations de routage (NLRI) sont échangées sous le format CIDR (Classless Inter-Domain Routing) qui consiste à ne coder que le préfixe des adresses (la partie réseau des adresses IP) et à agréger les routes contiguës.

Les routeurs BGP partenaires (internal peers si dans le même AS ou external peers si dans deux AS différents) doivent avoir au moins une de leur interface dans le même subnet IP.

-------------------------------------------------------------------------------------------------------

Le protocole BGP requiert un maillage complet de toutes les paires de routeurs au sein d’un AS (entre Internal peers). Afin de simplifier cette configuration pour les grands réseaux, la solution consiste à regrouper les routeurs dans des clusters BGP et à désigner un leader au sein de chaque cluster, appelé Route Reflector. Les échanges avec les routeurs d’autres AS (entre External peers) sont alors réalisés via les Routes Reflectors qui redistribuent les routes apprises aux routeurs BGP de leur AS respectif. Utilisé au sein d’un AS, le même protocole est appelé I-BGP (Internal BGP) tandis qu’utilisé entre AS, il est appelé E-BGP (External BGP). La différence réside dans les règles de diffusion des routes apprises : un préfixe d’un voisin I-BGP ne peut pas être annoncé à un autre voisin I-BGP, ce qui est en revanche possible avec des voisins E-BGP.

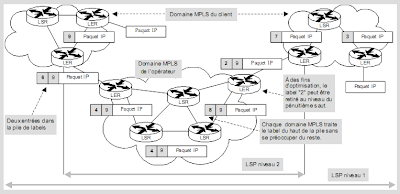

La commutation sur le WAN - MPLS

Une alternative au routage classique est la commutation MPLS (Multiprotocol Label Switching). Dans le premier cas, chaque routeur analyse l’en-tête des paquets IP et décide du routage en fonction d’une table représentant la topologie du réseau. Dans le second cas, l’analyse de l’entête est réalisée par le premier routeur qui ajoute un label, ce qui permet aux autres routeurs de commuter le paquet d’après ce label sans analyser le paquet. L’avantage immédiat est de réduire la taille des tables de routage et d’améliorer les performances.

L’idée originale était effectivement de réduire le temps de traitement des paquets en combinant le routage OSPF à la périphérie du réseau et la commutation ATM au cœur du réseau.

Plusieurs constructeurs ont ainsi proposé des solutions : Cisco avec Tag Switching, IBM avec ARIS (Aggregate Route-Based IP Switching), Ipsilon et Cascade. Ces approches propriétaires ont conduit l’IETF à se pencher sur le problème en 1997 puis à proposer le standard MPLS en janvier 2001, sorte de synthèse des précédentes solutions. Entre temps, les soucis de performances ont perdu de leur actualité grâce à la montée en puissance des routeurs, mais la principale technique mise en œuvre dans MPLS, c’est-à-dire la définition de chemins IP commutés, s’est avérée pouvoir remplir d’autres fonctions.

En effet, le concept de circuit virtuel au niveau IP, appelé LSP (Label Switched Path), permet de créer des chemins en fonction de différents critères et de leur appliquer des traitements différenciés. Le critère, qui permet d’affecter un paquet IP à un LSP, peut ainsi correspondre :

- à une adresse IP et/ou à un port TCP ou UDP ;

- à une classe de service ;

- à des choix d’ingénierie (dénommés communément traffic engineering), tels la répartition de trafic entre deux liaisons parallèles (load balancing), une route de secours en cas de panne du lien principal, etc.

Ces possibilités ouvrent la voie à trois applications :

- la création de réseaux logiques séparés, appelés VPN-MPLS ;

- le traitement différencié des flux de paquets en fonction de la classe de service qui leur est affectée ;

- l’orientation du trafic en fonction de l’état du réseau.

L’intérêt de reporter un maximum de fonctions au niveau 3 est qu’IP est présent partout, quel que soit le protocole de transport. On peut ainsi gérer de bout en bout et uniformément les VPN, la qualité de service et le trafic, que ce soit dans les réseaux privés en entreprise ou sur le réseau public Internet. En effet, MPLS est multiprotocole, car il repose sur n’importe quel protocole de niveau 2 (ATM, Frame Relay, PPP et Ethernet à ce jour) et peut être utilisé par n’importe quel protocole de niveau 3 (IPv4 et IPv6 à ce jour).

Fonctionnement de MPLS

Un LSP (Label Switched Path) est matérialisé par une succession de routeurs qui assignent les mêmes labels aux paquets IP ayant les mêmes caractéristiques (même adresse destination, même classe de service diffserv, etc.). Comme dans un réseau IP, les paquets sont mélangés, mais dans un domaine MPLS, les paquets d’un même LSP ne peuvent pas « voir » les autres paquets IP et sont traités différemment des autres LSP.

Le label peut correspondre au VPI/VCI d’un CV ATM (RFC 3035) ou au DLCI d’un CV Frame Relay (RFC 3034). Dans ce cas de figure, les commutateurs ATM et Frame Relay se comportent comme des routeurs MPLS.

-------------------------------------------------------------------------------------------------------

LE POINT SUR MPLS (RFC 3031 ET 3032)

Le protocole MPLS (Multiprotocol Label Switching) créé des circuits virtuels au niveau IP, appelés LSP (Label Switched Path), sur la base de critères, appelés FEC (Forwarding Equivalent Class), tels que les adresses destinations, les classes de services, le type d’application, etc. Tous les paquets correspondant à un même FEC emprunteront ainsi le même LSP et seront identifiés par les mêmes labels.

À la frontière d’un domaine MPLS, le paquet IP est pris en charge par un routeur de bordure (LER – Label Edge Router) à qui il ajoute (en entrée) ou retire (en sortie) un label. Les paquets sont ensuite commutés par des routeurs MPLS (LSR – Label Switch Router) qui ont la possibilité de modifier les labels.

Alors qu’un routeur classique traitera chaque paquet individuellement sur la base de sa table de routage et de l’entête IP, un LSR se contentera de commuter les paquets uniquement sur la base des labels, sans

s’occuper de quoi que ce soit d’autre.

Les labels sont affectés indépendamment par chaque routeur MPLS. Ils n’ont donc qu’une portée locale, entre deux LSR adjacents.

Chaque routeur MPLS indique au routeur situé en amont le label associé à tel FEC grâce au protocole de distribution des labels (LDP – Label Distribution Protocol – RFC 3036 à 3038 et 3215). À partir des tables de routage et des informations échangées entre LSR, LDP constitue une table de correspondance appelée LIB (Label Information Base) qui associe un FEC (dans le cas de LDP, un numéro de réseau ou une adresse de machine) à un ou plusieurs couples “ Identifiant d’espace de label / Label ”.

MPLS peut cependant utiliser d’autres protocoles pour distribuer les labels. Ainsi, des extensions de BGP (RFC 3107) et de RSVP (RFC 3209) ont été spécifiées à cet effet.

Il est possible de créer des hiérarchies de LSP, par exemple pour agréger des LSP dans un seul LSP sur une partie du chemin (création d’un tunnel) à l’instar d’ATM qui agrège plusieurs VC dans un VP (cf. chapitre 11), mais sur un seul niveau alors que MPLS n’est pas limité. Dans l’entête MPLS, les labels sont ainsi empilés par les LER de chaque domaine sur le mode LIFO (Last In, First Out). Il est alors possible d’imbriquer plusieurs domaines MPLS, chaque domaine ne traitant que le label situé au dessus de la pile.

À la différence d’un domaine MPLS, un tunnel LSP ne concerne que deux routeurs qu’ils soient d’ailleurs adjacents (tunnel routé saut par saut) ou non (tunnel routé explicitement).

Le routage MPLS peut être traité de deux manières :

• saut par saut, chaque LSR choisissant indépendamment le prochain saut pour chaque FEC sur la base des informations fournies par un protocole de routage tel qu’OSPF.

• explicitement, le LER d’entrée ou de sortie indiquant tout (routage explicite strict) ou partie (routage explicite lâche) des LSR à emprunter pour tel FEC.

Les protocoles de distribution de label permettant de créer des LSP saut par saut sont LDP et une extension de BGP (RFC 3107). Les protocoles de distribution de label permettant de créer des LSP explicites sont actuellement RSVP-TE (RSVP Traffic Engineering, RFC 3209) ou CR-LDP (Constraint-Based LDP, RFC 3212 à 3214).

Les LSP peuvent être créés avec LDP selon le mode de contrôle indépendant ou ordonné. Dans le premier cas, la diffusion des labels est réalisée par chaque LSR dès que possible, on pourrait dire de manière désordonnée, tandis que dans le second cas, les LSR ne diffusent les labels d’un FEC que s’il a reçu le label correspondant à ce FEC en provenance d’un routeur amont.

Plusieurs FEC peuvent être agrégés en un seul FEC, seul ce dernier étant alors lié à un label. Cela peut, par exemple, être le cas de FEC partageant les mêmes préfixes d’adresse. De même, plusieurs labels entrant peuvent être fusionnés en un seul label, ce qui revient à fusionner plusieurs flux auparavant distincts.

Les flux fusionnés ne peuvent alors plus être séparés.

-------------------------------------------------------------------------------------------------------

Les VPN-MPLS sont fonctionnellement équivalents aux VLAN Ethernet décrits au début de ce chapitre. Les premiers agissent au niveau 2, tandis que les seconds agissent au niveau 3.

L’exemple suivant est proposé à titre indicatif, car les implémentations actuelles sont encore propriétaires, notamment au niveau du protocole de diffusion de labels et de l’utilisation du champ « Exp ». Le lecteur pourra se tenir informé des évolutions de MPLS sur le site www.ietf.org/html.charters/mpls-charter.html.

-----------------------------------------------------------------------------------------------------

Article plus récent Article plus ancien